谷歌公布了一项重要研究成果–电影票房预测模型。该模型能够提前一个月预测电影上映首周的票房收入,准确度高达94%。这在业内引起了强烈讨论,不少内人士认为该模型非常适合好莱坞电影公司通过预测票房来及时调整电影营销战略,但同时也有吐槽者暗示谷歌的票房预测模型别有用心,旨在鼓动电影公司购买其搜索引擎广告。那么,孰是孰非,谷歌票房预测模型以及大数据在电影行业的应用是嘘头,还是大有来头,让我们来一探究竟。

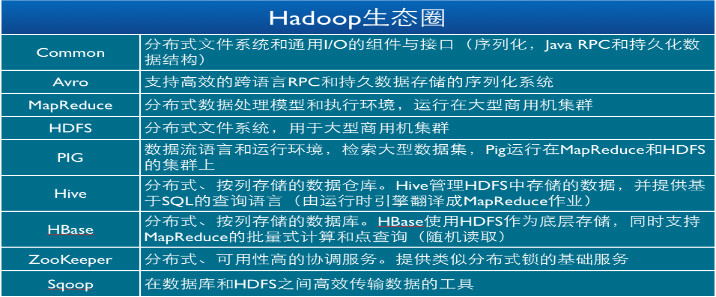

谷歌票房预测模型的基础:电影相关的搜索量与票房收入的关联

谷歌的票房预测模型是大数据分析技术在电影行业的一个重要应用。随着互联网的发展,人们越来越习惯于在网上搜索电影信息。据谷歌统计,从2011到2012年,电影相关的搜索量增长了56%。谷歌发现,电影相关的搜索量与票房收入之间存在很强的关联。

图1显示了2012年电影票房收入(红色)和电影的搜索量(灰色)的曲线(注:本文的所有图片均引用自谷歌的白皮书:QuantifyingMovieMagicwithGoogleSearch)。可以看到,两条曲线的起伏变化有着很强的相似性。

p1

图1.2012年票房收入与搜索量的曲线

(红色是票房收入,灰色是搜索量,横轴是月份,纵轴是数量)

更进一步地,谷歌把电影的搜索分成了两类:

I.涉及电影名的搜索(MovieTitleSearch);

II.不涉及电影名的搜索(Non-TitleFilm-RelatedSearch)。这类搜索不包含具体的名字,而是一些更宽泛的关键词搜索,如“热门电影”、“爱情片”、“好莱坞电影”等。

图2显示了票房收入与这两类搜索量之间的关系。从图上可以看到,大部分情况下,第I类搜索量超过第II类搜索量。但在电影淡季的时候(图中灰色椭圆区域,这时候票房收入较低),第I类搜索量会低于第II类搜索量。这符合常理,因为在淡季的时候知名度高的电影很少,人们往往用更宽泛的搜索来寻找想看的电影。

- p2

图2.2012年票房收入和两类搜索量的曲线

(红色代表票房收入,蓝色代表第I搜索,灰色代表第II类搜索,横轴是月份,纵轴是数量)

这一发现对电影的网络营销来说有一定的指导意义:在淡季的时候,电影公司可多购买相对宽泛的关键词的广告,而在旺季的时候,多购买涉及电影名的、更具体的关键词的广告。

提前一周预测票房,可达到92%的准确度

上面的讨论表明用电影的搜索量来预测票房是有可能的。那么,如果单纯使用搜索量来预测首周票房收入,效果怎么样?通过对2012年上映的99部电影的研究,谷歌发现仅依靠搜索量来预测是不够的。谷歌尝试构建了一个线性的模型,但只达到了70%的准确度(如图3)。

- p3

图3.搜索量与首周票房收入之间的关系

(横轴是搜索量,纵轴是首周票房收入,灰色点对应某部电影的搜索量与首周票房收入)

为了构建更加精确的预测模型,谷歌最终采用了四类指标:

(1)(电影放映前一周的)电影的搜索量

(2)(电影放映前一周的)电影广告的点击量

(3)上映影院数量

(4)同系列电影前几部的票房表现

其中每类指标又包含了多项类内指标。

在获取到每部电影的这些指标后,谷歌构建了一个线性回归模型(linearregressionmodel)模型,来建立这些指标和票房收入的关系。线性回归模型,在大数据分析领域里算是最基本的模型之一,它认为票房收入与这些指标之间是简单的线性关系。

图4展示了模型的效果,其中灰色点代表了实际的票房收入,红色点代表了预测的票房收入。可以看到,预测的结果与实际的结果差异很小。

- p4

图4.提前一周预测票房的效果

(横轴是搜索量,纵轴是首周票房收入,灰色点对应某部电影的首周票房收入,红色点对应预测的首周票房收入)

提前一个月预测票房,可达到94%的准确度

尽管提前一周预测可以达到92%的准确度,对于电影的营销来说,价值并不大,因为一周的时间往往很难调整营销策略,改善营销效果。因此,谷歌又进一步研究,使得模型可以提前一个月预测首周票房。

实现提前一个月预测的关键在于:谷歌采用了一项新的指标–电影预告片的搜索量。谷歌发现,预告片的搜索量比起电影的直接搜索量而言,可以更好的预测首周票房表现。这一点不难理解,因为在电影放映前一个月的时候,人们往往更多地搜索预告片。

仅使用预告片的搜索量仍然不够,因此谷歌的模型最终采用了三类指标:

(1)电影预告片的搜索量

(2)同系列电影前几部的票房表现

(3)档期的季节性特征

其中每类指标又包含了多项类内指标。

在获取到每部电影的这些指标后,谷歌再次构建了一个线性回归模型(linearregressionmodel)模型,来建立这些指标和票房收入的关系。

图5展示了模型的效果,其中灰色点代表了实际的票房收入,红色点代表了预测的票房收入。可以看到,预测结果与实际结果非常接近。

- p5

图5提前一个月预测票房的效果

(横轴是预告片搜索量,纵轴是首周票房收入,灰色点对应实际某部电影的首周票房收入,红色点对应预测的首周票房收入)

为什么谷歌采用了这么简单的模型

前面的分析中已经提到,谷歌采用的是数据分析中最简单的模型之一-线性回归模型。这对很多读者来说多少有点意外。为什么谷歌用的模型如此简单?

首先,线性模型虽然简单,但已经达到了很高的准确度(94%)。简单且效果好,是我们在实际应用中一直追求的。

其次,简单的模型易于被人们理解和分析。大数据分析技术的优势正是能够从大量数据中挖掘出人们可以理解的规律,从而加深对行业的理解。正是因为谷歌使用了线性预测模型,所以它很容易对各项指标的影响做出分析。例如谷歌的报告中给出了这样的分析结论:“距离电影上映一周的时候,如果一部影片比同类影片多获得25万搜索量,那么该片的首周票房就很可能比同类影片高出430万美元。若一部电影有搜索引擎广告,我们也可以通过其广告的点击量来推测票房表现——如果点击量超出同类电影2万,那该片首周票房将领先750万美元”。

对于电影的营销来说,掌握各项指标对票房收入的影响,可以优化营销策略,降低营销成本。谷歌的报告中指出,用户一般会通过多达13个渠道来了解电影的信息。票房预测模型的出现无疑使得营销策略的制定更加有效。

大数据分析在电影行业的应用前景:把模糊的行业经验变得更科学,更精准

票房预测模型的公布,让业内人士再次见证了大数据的成功应用。近年来,大数据在电影行业的应用越来越引起关注,比如此前谷歌利用搜索数据预测了奥斯卡获奖者,Neflix通过大数据分析深度挖掘了用户的喜好,捧红了《纸牌屋》等。但大数据对电影行业的价值到底如何,仍然众说纷纭。梦工厂CEO卡森伯格最近接受腾讯财经专访时发表了一个似乎悲观的态度:电影创作靠创造力,不靠数据分析。

要理解大数据对电影行业的影响,首先需要对大数据分析有正确的认识。大数据分析的本质,在于通过数据,更精准地挖掘用户的需求。而谁能掌握用户的需求,谁就可以引领行业的发展。谷歌的票房预测模型,本质上也是通过搜索量,挖掘出用户对电影的需求有多大,进而预测出票房收入。值得注意的是,谷歌的模型基于的只是宏观的搜索量的统计,对用户需求的挖掘相对表面。如何从搜索数据中更深地挖掘用户的需求将是未来的趋势之一。

既然大数据分析的核心是挖掘用户需求,所以一大核心问题是:哪些用户的需求是可以从数据中挖掘到的?要知道,并不是任何需求都可以被挖掘到,或者说可以被精准地挖掘到。能够通过大数据分析挖掘到的需求,一般是符合行业经验的,应当是业内人士觉得可以被挖掘的(有时候,挖掘出的需求可能会超出行业经验,甚至产生颠覆性的影响)。谷歌的预测模型的基本假设,是符合行业直觉的,即电影的搜索量越大,往往票房收入越大。模型能够提前一个月预测票房,也符合行业经验,正如谷歌的一项行业调研揭示的:大多数观众会在电影首映4周前去了解电影。数据分析技术,是把这种模糊的行业经验,变得更科学,变得更精准。而这一过程,很可能会深层次地改变电影行业。

要将大数据分析更广泛地应用于电影行业,可以从以下几个方面去探索:

一.我们可以获得哪些数据。大数据时代的特点是数据来源广泛,可以是业内发布的数据,也可以是来自搜索引擎、社交媒体等的数据。有些数据看似关联不强(比如社交媒体数据),但往往能从中挖掘到用户的潜在需求。

二.从数据中,我们想挖掘什么信息。谷歌的模型,挖掘了搜索量等数据与票房收入的关联;Netflix的模型,则挖掘了观众对不同电影的偏好,以及其他的行为特点。挖掘什么信息,一方面取决于我们有哪些数据,另一方面也取决于什么样的信息可能有助于商业决策。

三.有什么行业经验是可以结合的。单纯地数据分析,可能会找到很多规律,但这些规律未必是有实际价值的。只有当数据结合行业经验,才更容易形成精准的行业模型,从而产生巨大的价值。

而卡森伯格说的“不靠数据”,更多的是强调电影创作本身。电影的创作充满了艺术,是很难形成科学的规律的。即便如此,大数据对电影创作也可以起到一定的辅助作用。毕竟,了解观众的需求,也是电影创作的重要参考。